多益文法與字彙之10~使用Gemini 3練習英語交談

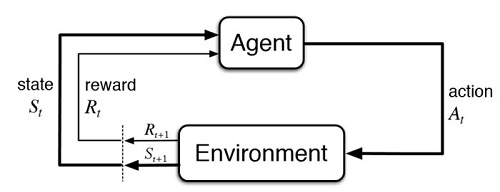

2-9:使用Gemini 3練習英語交談 我們從國小到國中,不時聽人家講什麼”仄仄平平仄平仄”,這些在課堂上,老師常常解釋得不清不楚的內容,學生當然是聽得一頭霧水。其實簡單的講,就是使用抑揚頓挫的語氣,來精準詮釋字裡行間要表達的意思。 所以我們學習文字,不論中文或英文,都是同時在練習書寫和發音的。但在AI裡面,語音辨識的神經網路,並沒有和自然語言處理放在一起訓練,所以在創作詩詞的時候,它只會押韻、不懂平仄。 可喜的是,這個情況已經在改善了,我們用一個英語笑話來說明,因為各地腔調不同,而導致話中原意被曲解的情況,AI已經有能力判斷出來了。 https://mobile-learning-testing.com/wp-content/uploads/2026/01/Joke1.mp4 上面的笑話表示,即使是南腔北調,文字和語音之間的無縫轉換,讓AI不僅只停留在字面理解的階段,它似乎也瞭解,說話語氣同樣是溝通表達重要的一部份。 和Grok比較起來,Gemini的回答速度稍慢,但也有可能是它重視上下文的理解,所以會多花一點時間來做推論。 理解上下文再做推論,讓AI提供的資訊符合提問者的需要,而一段精簡的文字,更方便我們評比此模型的邏輯能力。下面用第二個英語笑話,來看看AI能否聽得懂雙關語。 https://mobile-learning-testing.com/wp-content/uploads/2026/01/Joke2.mp4 看起來,AI真的是一個語文資優生,難怪它的名字就叫做「大型語言模型」。 我們用AI來學英文,Gemini是不錯的選擇,它不大會搶話,所以不用擔心它會搶你的拍子、中斷你學習的節奏。 但建議使用AI來學習會話的學員,不要天馬行空、毫不講究單字文法,就一個勁兒和AI東拉西扯,而應該把已經熟悉內文的讀本,拿來和AI討論內容。人工智慧果真是上知天文下知地理,它所理解的東西,甚至會比讀本還深入,有目的、有規劃的互動學習,總是會比較有效率的。

多益文法與字彙之10~使用Gemini 3練習英語交談 Read More »