自然語言處理之15~Gemini做程式設計

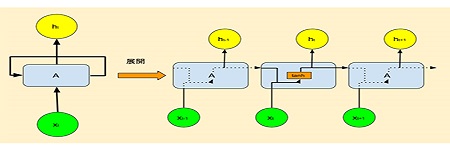

2-15:Gemini做程式設計 大型語言模型,像Claude或ChatGPT等,本身就是極其複雜的程式碼,由它們來寫普通編程,真是牛刀小試、小菜一碟,A piece of cake。 我們讓Gemini設計一個”打磚塊”網頁遊戲,使用的是HTML5語法,這對AI來講輕而易舉。只不過,設計出來的網頁內容,究竟要放到哪個網站平台,如何讓介面看起來簡潔友善,這些反而比較要花時間。 打磚塊遊戲 (Breakout) – 手機觸控版 點擊螢幕玩遊戲 使用 **手指拖曳** 或 **← → 鍵** 移動擋板。 點擊、觸控或按下 **空格鍵** 開始遊戲! 上圖的遊戲,重新整理之後,可觸控拖曳球拍來回擊圓球。在此要注意的是,這類遊戲是直接建立在網頁中,並不是可獨立下載啟動的App。 大約20年前,網頁上的遊戲動畫,幾乎清一色都由Flash包辦了,很多從業人員靠它風生水起。直到蘋果賈伯斯質疑,網頁內嵌這種檔案會產生明顯資安問題,自此,這一群人紛紛從雲端跌落谷底。 圖2-15-1. 早期Flash動畫遊戲也曾做得細緻生動。 這種小遊戲、小軟體,原本是初階程式人員可以著墨的地方,但不知不覺中,AI已經正在取代這類人力了。 中階人員倒還有一定的生存空間。如下圖中,我們要求AI設計強化學習的遊戲,結果它學習到43000回合了,仍舊欲振乏力。像這種整合遊戲模組、數學計算的進階程式設計,目前還是需要資深工程師的協助。 https://mobile-learning-testing.com/wp-content/uploads/2025/12/brick.mp4

自然語言處理之15~Gemini做程式設計 Read More »