3-1:馬可夫決策過程

增強式學習這幾年來廣受各方矚目,主要的原因,當然是它成功地被引用在ChatGPT當中。但除了大型語言模型,增強式學習還有很多重要的應用,例如像無人載具、機器人的路徑規劃,以及數位電路、核融合及渦輪引擎的效率最佳化設計等。

增強式學習的基本概念,在於透過多次訓練逐步形成最佳策略,以找出最大報酬的最適路徑。迷宮遊戲,是最常被拿來舉例說明的範本。

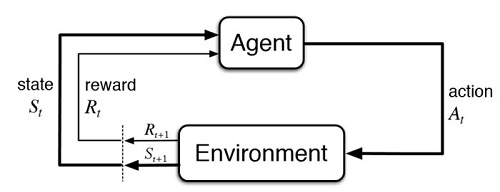

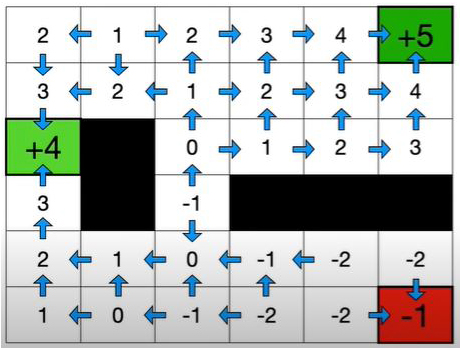

圖3-1-1上圖之中,橘色球形代表遊戲的主角(agent),整個6×6迷宮就是環境(environment),其中任何一個格子的x,y座標就是狀態(state),橘球要上下左右朝哪一方向移動,就是行動(action)。

走到相鄰任何格子的獎勵(reward)應為 -1,但有兩個格子獎勵為4和5,其中並有黑色的障礙禁止區。想要成功走完迷宮的基本邏輯思考,就是以最少的步數走到獎勵為5的格子,來獲得最大的“累積獎勵”(稱為“報酬”,return)。

圖3-1-1下圖之中,是在說明,經過多個回合(episode)的訓練,系統會慢慢計算出每個格子的價值(state value),agent在決定要朝哪個方向移動下一步時,就會傾向鄰近價值最高的格子,並更新目前所在格子的價值,這就是所謂的策略(policy)。

圖3-1-1. 迷宮遊戲,是增強式學習常用的範例。

迷宮遊戲只是增強式學習的起步,但已需要一些程式設計的基礎了,這方面,適當的Python語言訓練,加上良好的直覺(intuition)是很有幫助的。

學理方面,則必須面對比較不好掌握的統計機率。這個部份,馬可夫決策過程(Markov Decision Process, MDP)當中,有一個假設需要先瞭解。

這個假設是說,“目前的時序狀態,只取決於前一個時序的狀態與行動”。換句話講,它假設了前面的時序已包含了更前面時序的訊息。所以可以利用遞迴的做法,將所有時序的關係串接起來。

馬可夫先生(1856~1922),早年就讀彼德堡文法學校,格格不入。後來就讀聖彼得堡大學,在隨機過程領域做出重要貢獻。但他並未忘情早年訓練,曾利用馬可夫鏈來模擬俄國文學中輔音和元音的頭韻法。

圖3-2. 馬可夫(Markov)畢業自聖彼得堡大學,是俄國著名的數學家。